Дневник E2E Сборки: Как Я Собрал AI SERP Analyzer Соло за 3 Недели (Весь Стек и Процесс)

Ключевые Мысли (TL;DR):

- Создать полезный AI-инструмент (типа SERP Analyzer) соло – не просто реально, а эффективно. Весь процесс от идеи до MVP занял ~3 недели.

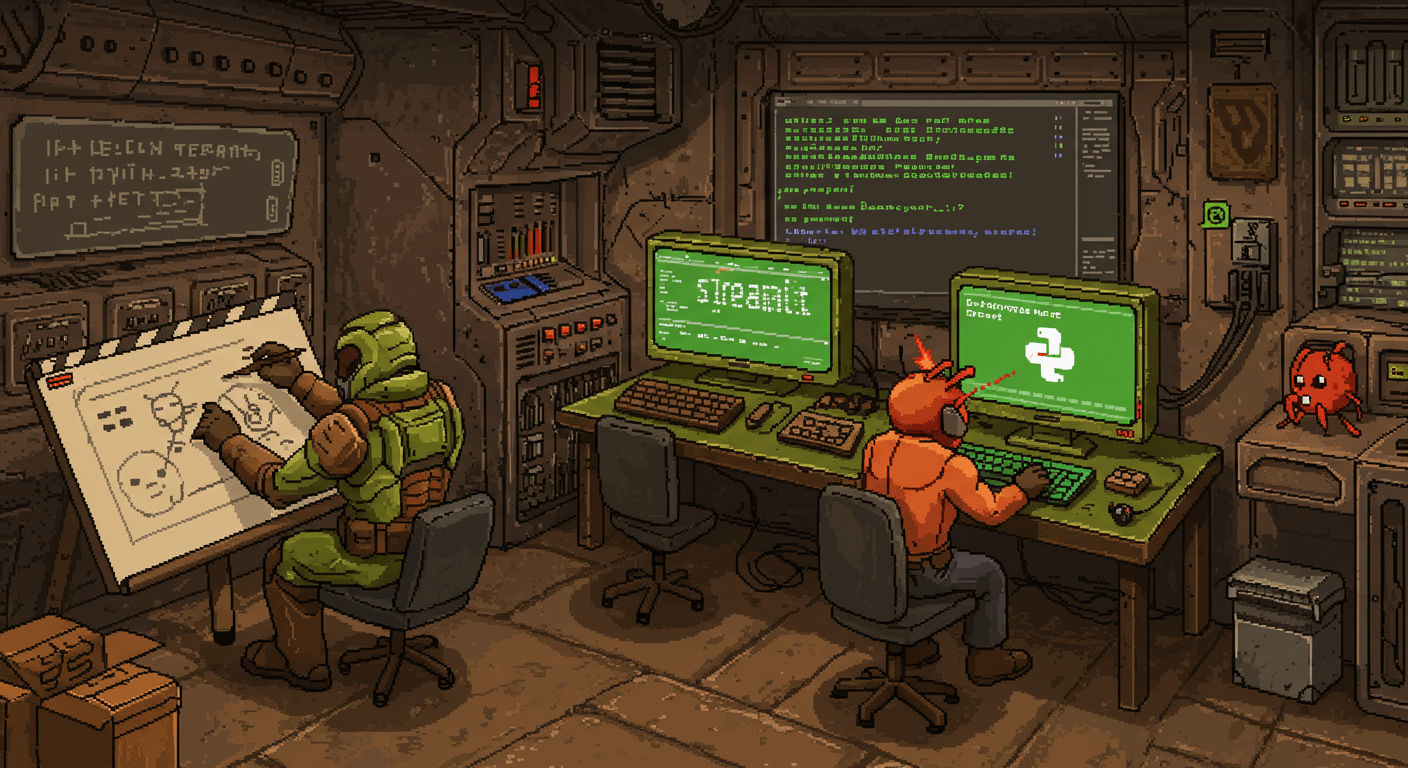

- Ключ к скорости – правильный стек: Python для AI-логики и Streamlit для UI. Это позволяет избежать месяцев традиционной веб-разработки.

- 90% успеха в работе с AI API (GPT-4, Claude) – это итеративный **промпт-инжиниринг**. Качество результата напрямую зависит от точности инструкций для модели.

- Валидация идеи через анализ спроса и конкурентов – **обязательный первый шаг**, который экономит недели бесполезной работы.

- Затраты на MVP могут быть ниже 1000 рублей, если использовать бесплатные тарифы хостинга и экономно расходовать API-кредиты.

- Готовый MVP можно монетизировать через SaaS-подписку, продажу как готового решения или как основу для консалтингового бизнеса.

Анализировать топ выдачи Google (SERP) для SEO – это ручной ад. Ты тратишь 2-3 часа, чтобы вникнуть в стратегию конкурентов по одному запросу. Это долго. Муторно. Легко упустить ключевые инсайты.

Готовые SaaS-инструменты, такие как Ahrefs или SEMrush, стоят сотни долларов в месяц и часто перегружены функциями, когда тебе нужен лишь быстрый срез данных.

А что, если нужен простой, быстрый AI-помощник? Который за 60 секунд покажет главное: какие темы раскрывают конкуренты, где у них пробелы в контенте, и какие базовые SEO-ошибки они допустили?

Можно ли такой AI-инструмент собрать соло, быстро и почти бесплатно? Я решил проверить. Этот дневник – честный рассказ о 3 неделях сборки моего AI SERP Analyzer. Весь процесс. Стек. Проблемы и выводы. Погнали!

Идея и Валидация (День 1-3): От Личной Боли к Бизнес-Гипотезе

Все началось с собственной боли. Я тратил часы на ручной анализ SERP для своих проектов. Захотелось автоматизировать хотя бы часть, чтобы фокусироваться на стратегии, а не на рутинном сборе данных.

День 1: Формулировка Боли и Поиск Спроса

Залез на SEO-форумы, в Telegram-чаты (типа "SEO-специалисты"), на Reddit (r/SEO). Искал посты с жалобами на ручной анализ, вопросы типа "как быстро проанализировать конкурентов". Увидел, что боль реальна и массова. Люди ищут решения, которые экономят время.

День 2: Анализ Конкурентов

Посмотрел на гигантов: Ahrefs, SEMrush, SurferSEO. Их сила — в комплексности. Но это и их слабость. Они мощные, но дорогие и сложные для быстрого анализа. Есть ли ниша для простого, быстрого AI-помощника, который решает одну задачу, но делает ее хорошо? Кажется, да. Это классическая стратегия "unbundling" — откусить одну фичу у большого продукта и сделать ее лучше/дешевле.

День 3: Определение MVP (Minimum Viable Product)

Решил: MVP должен делать минимум, но полезный. Вводишь ключ -> он парсит топ-10 Google -> AI анализирует и показывает:

- Основные темы и подтемы (из H2/H3) у конкурентов.

- Семантическое ядро (ключевые слова), которые они используют.

- Очевидные пробелы в контенте (что они НЕ освещают, но что ищут пользователи).

- Базовые on-page SEO-рекомендации (оценка Title, Description, H1).

Никаких сложных метрик, только быстрые, actionable инсайты. Цель – сэкономить первые 30-60 минут ручного анализа и дать направление для создания контента.

Выбор Стека (День 4): Скорость Решает Всё

Ключевой момент. Для MVP соло-разработчика скорость и простота важнее всего. Неправильный выбор стека может превратить 3-недельный проект в 3-месячный.

Бэкенд: Python – Без Вариантов

Почему? Это язык AI-разработки №1. Огромное количество готовых библиотек для веб-скрейпинга (requests, BeautifulSoup), работы с AI API (openai, anthropic), анализа текста (nltk, spaCy). Плюс, я его знаю, что ускоряет процесс.

Фронтенд: Битва Low-Code vs No-Code

Сразу отбросил классический веб-стек (React/Vue + FastAPI/Django) – это долго для MVP. Рассматривал:

| Платформа | Плюсы | Минусы | Лучше для |

|---|---|---|---|

| Streamlit | Максимальная скорость, нативно для Python, простота. | Ограниченный кастомный дизайн, может тормозить. | Быстрых MVP, Data Science дашбордов. |

| Gradio | Очень просто для демо AI-моделей. | Еще более ограниченный UI, чем у Streamlit. | Презентации моделей. |

| No-Code (Softr + API) | Красивый UI за часы, не дни. | Сложнее интеграция, ограничения платформы. | Продуктов, где UI важнее логики. |

Выбрал Streamlit. Почему? Максимальная скорость для MVP, где функциональность важнее внешнего вида. Вся разработка AI и UI ведется на одном языке — Python. [Больше о моем подходе к соло-стеку...]

Разработка Бэкенда - Ядро Системы (Неделя 1)

Самая сложная и интересная часть. Здесь создается вся ценность продукта.

👆 Наведите курсор на компоненты для детальной информации о каждом элементе системы.

День 5-7: Парсинг SERP и Скрейпинг Страниц

Начал с парсинга Google. Использовать `requests` + `BeautifulSoup` напрямую — плохая идея. Google банит простые запросы почти мгновенно. Вместо этого я использовал платный SERP API (например, SerpAPI или Bright Data). Это немного дороже, но экономит десятки часов на борьбе с блокировками, ротацией прокси и решением капч.

Дальше – скрейпинг контента с полученных URL. Задача – вытащить основной текст статьи, игнорируя меню, футеры, рекламу. Искал по тегам , , и чистил от "мусорных" тегов (nav, footer, script).

# Пример кода для извлечения основного текста

import requests

from bs4 import BeautifulSoup

def scrape_article_text(url):

try:

response = requests.get(url, timeout=10)

soup = BeautifulSoup(response.content, 'html.parser')

# Удаляем ненужные теги

for tag in soup(['nav', 'footer', 'script', 'style']):

tag.decompose()

# Ищем основной контент

article_body = soup.find('article') or soup.find('main') or soup.body

return article_body.get_text(separator='\\n', strip=True)

except requests.RequestException as e:

return f"Error scraping {url}: {e}"

День 8-10: Искусство Промпт-Инжиниринга

Это сердце инструмента. Использовал OpenAI API (GPT-4o для максимального качества). Простой промпт "проанализируй текст" не работает. Нужны четкие, структурированные запросы с ролями и примерами.

Пример итераций для извлечения тем:

- Промпт 1 (Плохой): "Выдели темы из этого текста." -> Результат: Общий, неструктурированный мусор.

- Промпт 2 (Лучше): "Ты SEO-аналитик. Проанализируй текст статьи. Извлеки основные темы, обсуждаемые в подзаголовках H2 и H3." -> Результат: Уже лучше, но часто пропускает детали или добавляет лишнее.

- Промпт 3 (Отличный):

-> Результат: Структурированный, точный и готовый к использованию.Действуй как опытный SEO-копирайтер с 10-летним стажем. Вот текст статьи: [ВСТАВИТЬ ТЕКСТ СТАТЬИ] Твоя задача: 1. Проанализируй структуру и содержание текста. 2. Извлеки ключевые темы и подтемы, которые раскрывает автор. 3. Определи главный интент пользователя, на который отвечает статья (информационный, коммерческий, транзакционный). 4. Найди контентные пробелы: какие важные аспекты темы [ВСТАВИТЬ КЛЮЧЕВОЕ СЛОВО] НЕ раскрыты в тексте? 5. Выведи результат в формате JSON со следующими ключами: "main_intent", "key_themes", "content_gaps".

Аналогично итерировал промпты для анализа тональности, базовых SEO-рекомендаций ("Оцени Title, Description, H1 по критериям SEO для ключа [Ключ] и дай рекомендации по улучшению").

Сборка Интерфейса на Streamlit (Неделя 2)

Здесь все относительно просто, если не гнаться за супер-дизайном на этапе MVP.

День 12-14: Базовый UI

Использовал стандартные компоненты Streamlit:

st.text_input("Введите ключевое слово:")- для ввода ключа.st.button("Анализировать!")- для запуска анализа.st.spinner("Анализирую SERP... Это может занять до 2 минут.")- для индикации процесса.st.markdown(),st.header(),st.subheader()- для вывода результатов.st.expander("Показать детальный анализ конкурента №1")- чтобы не загромождать вывод и сделать его интерактивным.

Главное – связать кнопку с вызовом бэкенд-функции анализа и красиво представить полученный JSON.

Тестирование, Деплой и Монетизация (Неделя 3)

День 17-18: Тестирование

Прогнал инструмент на 20-30 разных ключах. Сравнивал результаты AI-анализа с тем, что вижу глазами. Корректировал промпты для большей точности.

День 19: Деплой

Задеплоил на Streamlit Cloud. Это невероятно просто: подключаешь GitHub репо -> выбираешь ветку -> нажимаешь Deploy. Бесплатного тарифа хватает для MVP. Альтернатива: запаковать в Docker и залить на дешевый VPS (дольше, но больше контроля).

День 20-21: Стратегии Монетизации

Собранный инструмент – это актив. Как его монетизировать?

| Модель | Описание | Плюсы | Минусы |

|---|---|---|---|

| SaaS-подписка | Ежемесячная плата за доступ ($19-49/мес). | Предсказуемый доход (MRR). | Нужна поддержка, маркетинг, биллинг. |

| Pay-Per-Use | Оплата за каждый анализ ($0.5-2 за SERP). | Низкий барьер для входа пользователей. | Нестабильный доход. |

| Freemium | 3-5 бесплатных анализов в день, дальше – подписка. | Легко привлекать пользователей. | Сложно конвертировать в платящих. |

| Внутренний инструмент для консалтинга | Использовать для ускорения своей работы и продажи услуг. | Мгновенная ценность, повышение чека. | Не масштабируется как SaaS. |

Для соло-разработчика самый быстрый путь к деньгам – использовать инструмент для консалтинга или продавать как Done-for-you решение.

Затраты (Реальные Цифры)

- API Вызовы (OpenAI + SERP API): На тесты ушло суммарно около 500-800 рублей. GPT-4o значительно дешевле предыдущих версий, что делает экономику проекта еще более привлекательной.

- Хостинг (Streamlit Cloud): 0 рублей (на бесплатном тарифе).

- Время: ~3 недели неполного рабочего дня. Чистого времени – часов 40-50.

Итого: Меньше 1000 рублей деньгами.

Выводы и Следующие Шаги

- Реально ли собрать AI инструмент соло? Абсолютно ДА. AI + Low-Code/No-Code – это суперсила для соло-предпринимателей. [Мой подход к соло-разработке...]

- Что получилось? Простой, но рабочий инструмент, который реально экономит время на рутинном анализе. [См. в моем Product Hub...]

- Как развивать? Добавить больше метрик (backlinks, traffic - через платные API), улучшить UI (возможно, перейти на Softr+API), и запустить как SaaS с подпиской.

Заключение: Хватит Читать, Начни Строить!

Этот эксперимент доказал: сегодня один человек может создавать полезные AI-инструменты быстро и с минимальным бюджетом. Главное – четко определить MVP, выбрать правильный стек и итеративно улучшать.

Перестаньте просто потреблять контент про AI. Возьмите одну из идей, описанных в моем блоге, и начните строить свой собственный продукт!

=> Больше Разборов Реальных AI-Проектов в Telegram => Есть Идея для AI-Инструмента? Обсудим Партнерство